http://www.cnblogs.com/tolimit/p/5481419.html

內存回收詳解見linux內存源碼分析 - 內存回收(整體流程),在直接內存回收過程中,有可能會造成當前需要分配內存的進程被加入一個等待隊列,當整個node的空閒頁數量滿足要求時,由kswapd喚醒它重新獲取內存。這個等待隊列頭就是node結點描述符pgdat中的pfmemalloc_wait。如果當前進程加入到了pgdat->pfmemalloc_wait這個等待隊列中,那麼進程就不會進行直接內存回收,而是由kswapd喚醒後直接進行內存分配。

直接內存回收執行路徑是:

__alloc_pages_slowpath() -> __alloc_pages_direct_reclaim() -> __perform_reclaim() -> try_to_free_pages() -> do_try_to_free_pages() -> shrink_zones() -> shrink_zone()

在__alloc_pages_slowpath()中可能喚醒了所有node的kswapd內核線程,也可能沒有喚醒,每個node的kswapd是否在__alloc_pages_slowpath()中被喚醒有兩個條件:

分配標志中沒有__GFP_NO_KSWAPD,只有在透明大頁的分配過程中會有這個標志。

node中有至少一個zone的空閒頁框沒有達到 空閒頁框數量 >= high閥值 + 1 << order + 保留內存,或者有至少一個zone需要進行內存壓縮,這兩種情況node的kswapd都會被喚醒。

而在kswapd中會對node中每一個不平衡的zone進行內存回收,直到所有zone都滿足

zone分配頁框後剩余的頁框數量 > 此zone的high閥值 + 此zone保留的頁框數量。kswapd就會停止內存回收,然後喚醒在等待隊列的進程。

之後進程由於內存不足,對zonelist進行直接回收時,會調用到try_to_free_pages(),在這個函數內,決定了進程是否加入到node結點的pgdat->pfmemalloc_wait這個等待隊列中,如下:

unsigned long try_to_free_pages(struct zonelist *zonelist, int order,

gfp_t gfp_mask, nodemask_t *nodemask)

{

unsigned long nr_reclaimed;

struct scan_control sc = {

/* 打算回收32個頁框 */

.nr_to_reclaim = SWAP_CLUSTER_MAX,

.gfp_mask = (gfp_mask = memalloc_noio_flags(gfp_mask)),

/* 本次內存分配的order值 */

.order = order,

/* 允許進行回收的node掩碼 */

.nodemask = nodemask,

/* 優先級為默認的12 */

.priority = DEF_PRIORITY,

/* 與/proc/sys/vm/laptop_mode文件有關

* laptop_mode為0,則允許進行回寫操作,即使允許回寫,直接內存回收也不能對髒文件頁進行回寫

* 不過允許回寫時,可以對非文件頁進行回寫

*/

.may_writepage = !laptop_mode,

/* 允許進行unmap操作 */

.may_unmap = 1,

/* 允許進行非文件頁的操作 */

.may_swap = 1,

};

/*

* Do not enter reclaim if fatal signal was delivered while throttled.

* 1 is returned so that the page allocator does not OOM kill at this

* point.

*/

/* 當zonelist中獲取到的第一個node平衡,則返回,如果獲取到的第一個node不平衡,則將當前進程加入到pgdat->pfmemalloc_wait這個等待隊列中

* 這個等待隊列會在kswapd進行內存回收時,如果讓node平衡了,則會喚醒這個等待隊列中的進程

* 判斷node平衡的標准:

* 此node的ZONE_DMA和ZONE_NORMAL的總共空閒頁框數量 是否大於 此node的ZONE_DMA和ZONE_NORMAL的平均min閥值數量,大於則說明node平衡

* 加入pgdat->pfmemalloc_wait的情況

* 1.如果分配標志禁止了文件系統操作,則將要進行內存回收的進程設置為TASK_INTERRUPTIBLE狀態,然後加入到node的pgdat->pfmemalloc_wait,並且會設置超時時間為1s

* 2.如果分配標志沒有禁止了文件系統操作,則將要進行內存回收的進程加入到node的pgdat->pfmemalloc_wait,並設置為TASK_KILLABLE狀態,表示允許 TASK_UNINTERRUPTIBLE 響應致命信號的狀態

* 返回真,表示此進程加入過pgdat->pfmemalloc_wait等待隊列,並且已經被喚醒

* 返回假,表示此進程沒有加入過pgdat->pfmemalloc_wait等待隊列

*/

if (throttle_direct_reclaim(gfp_mask, zonelist, nodemask))

return 1;

trace_mm_vmscan_direct_reclaim_begin(order,

sc.may_writepage,

gfp_mask);

/* 進行內存回收,有三種情況到這裡

* 1.當前進程為內核線程

* 2.最優node是平衡的,當前進程沒有加入到pgdat->pfmemalloc_wait中

* 3.當前進程接收到了kill信號

*/

nr_reclaimed = do_try_to_free_pages(zonelist, &sc);

trace_mm_vmscan_direct_reclaim_end(nr_reclaimed);

return nr_reclaimed;

}

主要通過throttle_direct_reclaim()函數判斷是否加入到pgdat->pfmemalloc_wait等待隊列中,主要看此函數:

/* 當zonelist中第一個node平衡,則返回,如果node不平衡,則將當前進程加入到pgdat->pfmemalloc_wait這個等待隊列中

* 這個等待隊列會在kswapd進行內存回收時,如果讓node平衡了,則會喚醒這個等待隊列中的進程

* 判斷node平衡的標准:

* 此node的ZONE_DMA和ZONE_NORMAL的總共空閒頁框數量 是否大於 此node的ZONE_DMA和ZONE_NORMAL的平均min閥值數量,大於則說明node平衡

* 加入pgdat->pfmemalloc_wait的情況

* 1.如果分配標志禁止了文件系統操作,則將要進行內存回收的進程設置為TASK_INTERRUPTIBLE狀態,然後加入到node的pgdat->pfmemalloc_wait,並且會設置超時時間為1s

* 2.如果分配標志沒有禁止了文件系統操作,則將要進行內存回收的進程加入到node的pgdat->pfmemalloc_wait,並設置為TASK_KILLABLE狀態,表示允許 TASK_UNINTERRUPTIBLE 響應致命信號的狀態

*/

static bool throttle_direct_reclaim(gfp_t gfp_mask, struct zonelist *zonelist,

nodemask_t *nodemask)

{

struct zoneref *z;

struct zone *zone;

pg_data_t *pgdat = NULL;

/* 如果標記了PF_KTHREAD,表示此進程是一個內核線程,則不會往下執行 */

if (current->flags & PF_KTHREAD)

goto out;

/* 此進程已經接收到了kill信號,准備要被殺掉了 */

if (fatal_signal_pending(current))

goto out;

/* 遍歷zonelist,但是裡面只會在獲取到第一個pgdat時就跳出 */

for_each_zone_zonelist_nodemask(zone, z, zonelist,

gfp_mask, nodemask) {

/* 只遍歷ZONE_NORMAL和ZONE_DMA區 */

if (zone_idx(zone) > ZONE_NORMAL)

continue;

/* 獲取zone對應的node */

pgdat = zone->zone_pgdat;

/* 判斷node是否平衡,如果平衡,則返回真

* 如果不平衡,如果此node的kswapd沒有被喚醒,則喚醒,並且這裡喚醒kswapd只會對ZONE_NORMAL以下的zone進行內存回收

* node是否平衡的判斷標准是:

* 此node的ZONE_DMA和ZONE_NORMAL的總共空閒頁框數量 是否大於 此node的ZONE_DMA和ZONE_NORMAL的平均min閥值數量,大於則說明node平衡

*/

if (pfmemalloc_watermark_ok(pgdat))

goto out;

break;

}

if (!pgdat)

goto out;

count_vm_event(PGSCAN_DIRECT_THROTTLE);

if (!(gfp_mask & __GFP_FS)) {

/* 如果分配標志禁止了文件系統操作,則將要進行內存回收的進程設置為TASK_INTERRUPTIBLE狀態,然後加入到node的pgdat->pfmemalloc_wait,並且會設置超時時間為1s

* 1.pfmemalloc_watermark_ok(pgdat)為真時被喚醒,而1s沒超時,返回剩余timeout(jiffies)

* 2.睡眠超過1s時會喚醒,而pfmemalloc_watermark_ok(pgdat)此時為真,返回1

* 3.睡眠超過1s時會喚醒,而pfmemalloc_watermark_ok(pgdat)此時為假,返回0

* 4.接收到信號被喚醒,返回-ERESTARTSYS

*/

wait_event_interruptible_timeout(pgdat->pfmemalloc_wait,

pfmemalloc_watermark_ok(pgdat), HZ);

goto check_pending;

}

/* Throttle until kswapd wakes the process */

/* 如果分配標志沒有禁止了文件系統操作,則將要進行內存回收的進程加入到node的pgdat->pfmemalloc_wait,並設置為TASK_KILLABLE狀態,表示允許 TASK_UNINTERRUPTIBLE 響應致命信號的狀態

* 這些進程在兩種情況下被喚醒

* 1.pfmemalloc_watermark_ok(pgdat)為真時

* 2.接收到致命信號時

*/

wait_event_killable(zone->zone_pgdat->pfmemalloc_wait,

pfmemalloc_watermark_ok(pgdat));

check_pending:

/* 如果加入到了pgdat->pfmemalloc_wait後被喚醒,就會執行到這 */

/* 喚醒後再次檢查當前進程是否接受到了kill信號,准備退出 */

if (fatal_signal_pending(current))

return true;

out:

return false;

}

有四點需要注意:

當前進程已經接收到kill信號,則不會將其加入到pgdat->pfmemalloc_wait中。

只獲取第一個node,也就是當前進程最希望從此node中分配到內存。

判斷一個node是否平衡的條件是:此node的ZONE_NORMAL和ZONE_DMA兩個區的空閒頁框數量 > 此node的ZONE_NORMAL和ZONE_DMA兩個區的平均min閥值。如果不平衡,則加入到pgdat->pfmemalloc_wait等待隊列中,如果平衡,則直接返回,並由當前進程自己進行直接內存回收。

如果當前進程分配內存時使用的標志沒有__GFP_FS,則加入pgdat->pfmemalloc_wait中會有一個超時限制,為1s。並且加入後的狀態是TASK_INTERRUPTABLE。

其他情況的進程加入到pgdat->pfmemalloc_wait中沒有超時限制,並且狀態是TASK_KILLABLE。

如果進程加入到了node的pgdat->pfmemalloc_wait等待隊列中。在此node的kswapd進行內存回收後,會通過再次判斷此node是否平衡來喚醒這些進程,如果node平衡,則喚醒這些進程,否則不喚醒。實際上,不喚醒也說明了node沒有平衡,kswapd還是會繼續進行內存回收,最後kswapd實在沒辦法讓node達到平衡水平下,會在kswapd睡眠前,將這些進程全部進行喚醒。

zone的保留內存

之前很多地方說明到,判斷一個zone是否達到閥值,主要通過zone_watermark_ok()函數實現的,而在此函數中,又以 zone當前空閒內存 >= zone閥值(min/low/high) + 1 << order + 保留內存 這個公式進行判斷的,而對於zone閥值和1<<order都很好理解,這裡主要說說最後的那個保留內存。我們知道,如果打算從ZONE_HIGHMEM進行內存分配時,使用的zonelist是ZONE_HIGHMEM -> ZONE_NORMAL -> ZONE_DMA,當ZONE_HIGHMEM沒有足夠內存時,就會去ZONE_NORMAL和ZONE_DMA進行分配,這樣會造成一種情況,有可能ZONE_NORMAL和ZONE_DMA的內存都被本應該從ZONE_HIGHMEM分配的內存占完了,特定需要從ZONE_NORMAL和ZONE_DMA分配的內存則無法進行分配,所以內核設計了一個功能,就是讓其他ZONE內存不足時,可以在本ZONE進行內存分配,但是必須保留一些頁框出來,不能讓你所有都用完,而應該從本ZONE進行分配的時候則沒辦法獲取頁框,這個值就保存在struct

zone中:

struct zone

{

......

long lowmem_reserve[MAX_NR_ZONES];

......

}

注意是以數組保存這個必須保留的頁框數量的,而數組長度是node中zone的數量,為什麼要這樣組織,其實很好理解,對於對不同的zone進行的內存分配,如果因為目標zone的內存不足導致從本zone進行分配時,會因為目標zone的不同而保留的頁框數量不同,比如說,一次內存分配本來打算在ZONE_HIGHMEM進行分配,然後內存不足,最後到了ZONE_DMA進行分配,這時候ZONE_DMA使用的保留內存數量就是lowmem_reserve[ZONE_HIGHMEM];而如果一次內存分配是打算在ZONE_NORMAL進行分配,因為內存不足導致到了ZONE_DMA進行分配,這時候ZONE_DMA使用的保留內存數量就是lowmem_reserve[ZONE_NORMAL]。這樣,對於這兩次內存分配過程中,當對ZONE_DMA調用zone_watermark_ok()進行閥值判斷能否從ZONE_DMA進行內存分配時,公式就會變為 zone當前空閒內存

>= zone閥值(min/low/high) + 1 << order + lowmem_reserve[ZONE_HIGHMEM] 和 zone當前空閒內存 >= zone閥值(min/low/high) + 1 << order + lowmem_reserve[ZONE_NORMAL]。這樣就可能會因為lowmem_reserve[ZONE_HIGHMEM]和lowmem_reserve[ZONE_NORMAL]的不同,導致一種能夠順利從ZONE_DMA分配到內存,另一種不能夠。而對於本來就打算從本zone進行內存分配時,比如本來就打算從ZONE_DMA進行內存分配,就會使用lowmem_reserve[ZONE_DMA],而由於zone本來就是ZONE_DMA,所以ZONE_DMA的lowmem_reserve[ZONE_DMA]為0,也就是,當打算從ZONE_DMA進行內存分配時,會使用zone_watermark_ok()判斷ZONE_DMA是否達到閥值,而判斷公式中的保留內存lowmem_reverve[ZONE_DMA]是為0的。同理,當本來就打算從ZONE_NORMAL進行內存分配,並通過zone_watermark_ok()對ZONE_NORMAL進行閥值判斷時,會使用ZONE_NORMAL區的lowmem_reserve[ZONE_NORAML],這個值也是0。對於ZONE_NORMAL區而言,它的lowmem_reserve[ZONE_DMA]和lowmem_reserve[ZONE_NORMAL]為0,因為需要從ZONE_DMA進行內存分配時,即使內存不足也不會到ZONE_NORMAL進行分配,而由於自己又是ZONE_NORMAL區,所有這兩個數為0;而對於ZONE_HIGHMEM,它的lowmem_reserve[]中所有值都為0,它不必為其他zone限制保留內存,因為其他zone當內存不足時不會到ZONE_HIGHMEM中進行嘗試分配內存。

可以通過cat /proc/zoneinfo查看這個數組中的值為多少:

這個是我的ZONE_DMA的區的參數,可以看到,對應ZONE_DMA就是為0,然後ZONE_NORMAL和ZONE_HIGHMEM都為1854,最後一個是虛擬的zone,叫ZONE_MOVABLE。

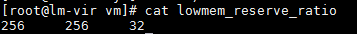

對於zone保留內存的多少,可以通過/proc/sys/vm/lowmem_reserve_ratio進行修改。具體可見內核文檔Documentation/sysctl/vm.txt,我的系統默認的lowmem_reserve_ratio如下:

這個256和32代表的是1/256和1/32。而第一個256用於代表DMA區的,第二個256代表NORMAL區的,第三個32代表HIGHMEM區的,計算公式是:

ZONE_DMA對於ZONE_NORMAL分配需要保留的內存:

zone_dma->lowmem_reserve[ZONE_NORMAL] = zone_normal.managed / lowmem_reserve_ratio[ZONE_DMA]

ZONE_DMA對於ZONE_HIGHMEM分配需要保留的內存:

zone_dma->lowmem_reserve[ZONE_HIGHMEM] = zone_highmem.managed / lowmem_reserve_ratio[ZONE_HIGHMEM]