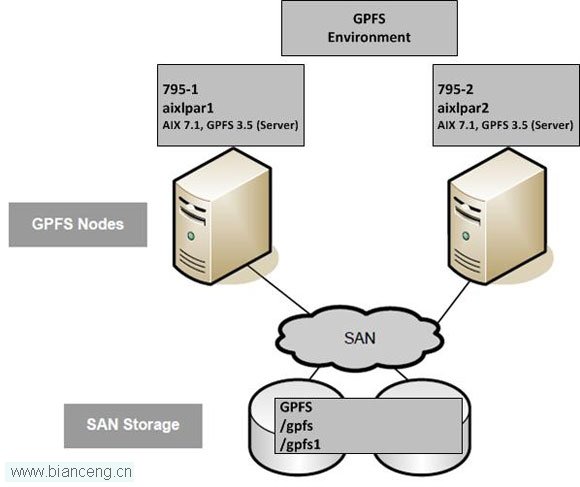

本文的目的是為在 AIX 上安裝和配置一個簡單的雙節點 GPFS 集群提供一個分步指南。下圖提供了集群配置的可視化表示形式。

GPFS 提供了一個真正的 “共享文件系統” 功能,具有卓越的性能和可伸縮性。GPFS 允許一組計算機通過一個公共的存儲區域網絡(SAN)基礎架構、一個網絡或混合連接類型來同時訪問一組公共的文件數據。GPFS 提供了存儲管理、信息生命周期管理工具和集中式管理,還允許從提供了一個全局命名空間的遠程 GPFS 集群對文件系統進行共享訪問。

GPFS 提供了數據分層、復制和其他許多高級特性。根據您的需要,配置可能很簡單,也可能很復雜。

為 GPFS 准備好 AIX 環境

我們假設,您已經為 GPFS 購買了必要的許可和軟件。如果有可用的 GPFS 軟件介質,那麼可以將 GPFS 文件集復制到需要運行 GPFS 的每個 AIX 節點上。

在本文中,每個分區都是利用 AIX version 7.1, Technology Level 2, Service Pack 1 構建的:

# oslevel -s

7100-02-01-1245

每個 AIX 系統都被配置為有 7 個 SAN 磁盤。一個磁盤用於 AIX 操作系統(rootvg),其余 6 個磁盤供 GPFS 使用。

# lspv

hdisk0 00c334b6af00e77b rootvg active

hdisk1 none none

hdisk2 none none

hdisk3 none none

hdisk4 none none

hdisk5 none none

hdisk6 none none

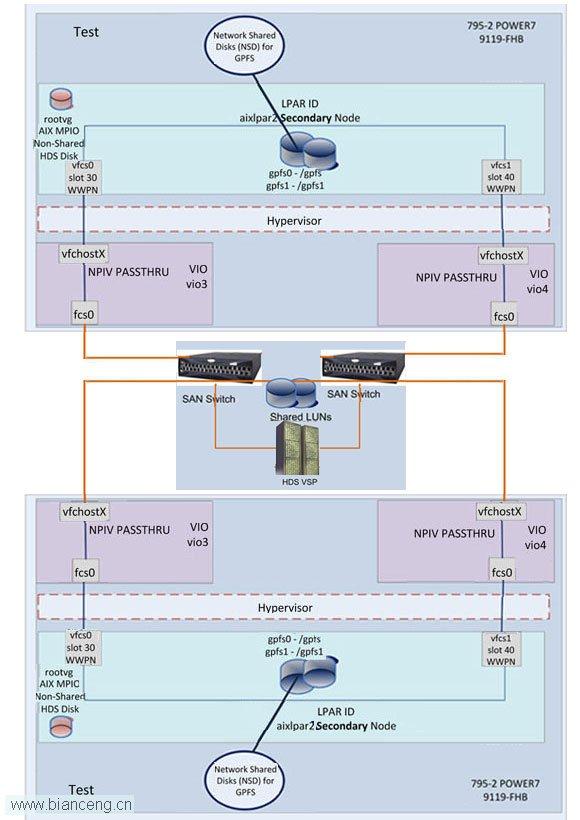

SAN 磁盤(將與 GPFS 一起使用)被分配到兩個節點(也就是說,在這兩個分區之間共享它們)。兩個 AIX 分區都配置了虛擬光纖通道適配器,並通過 SAN 訪問它們的共享存儲,如下圖所示。

使用 chdev 命令,對每個 hdisk 更改以下屬性,如下表所示。

lsattr 命令可用於驗證每個屬性是否被設置為正確的值:

# lsattr -El hdisk6 –a queue_depth –q algorithm –a reserve_policy

algorithm round_robin Algorithm True

queue_depth 32 Queue DEPTH True

reserve_policy no_reserve Reserve Policy True

下一步是配置 Secure Shell (SSH),使這兩個節點可以互相通信。在構建 GPFS 集群時,必須確保集群中的節點擁有正確配置的 SSH,這樣它們就不再需要進行密碼身份驗證。這需要配置 Rivest-Shamir-Adleman algorithm (RSA) 密鑰對,以完成 root 用戶 SSH 配置。需要在兩個方向上對 GPFS 集群中的所有節點進行此配置。

GPFS 中的 mm 命令需要在身份驗證後才能工作。如果沒有正確配置密鑰,這些命令每次都會提示您輸入 root 密碼,並且 GPFS 集群可能會失敗。測試此配置的一個好方法是,確保 ssh 命令可以不受到 root 密碼請求的阻礙,繼續正常工作。

您可以參考在 AIX 上 配置 SSH 密鑰的分步指南 :

可以在每個節點上使用以下命令,確認各節點都能夠使用 SSH 進行彼此(無阻礙的)通信:

aixlpar1# ssh aixlpar1a date

aixlpar1# ssh aixlpar2a date

aixlpar2# ssh aixlpar2a date

aixlpar2# ssh aixlpar1a date

若 SSH 正常工作,則為 root 用戶配置 WCOLL (Working Collective) 環境變量。例如,創建一個文本文件,以每行一個節點的形式列出所有節點:

# vi /usr/local/etc/gfps-nodes.list

aixlpar1a

aixlpar2a

將節點文件復制到集群中的所有節點。

將以下條目添加到 root 用戶 .kshrc 文件。這將允許 root 用戶在 GPFS 集群中的所有節點上使用 dsh 或 mmdsh 命令來執行命令。

export WCOLL=/usr/local/etc/gfps-nodes.list

應該修改 root 用戶 PATH ,確保系統管理員可以使用所有 GPFS mm 命令。將以下條目添加到 root 用戶的 .kshrc 文件。

export PATH=$PATH:/usr/sbin/acct:/usr/lpp/mmfs/bin

文件 /etc/hosts 在 GPFS 集群中的所有節點上都應該是一致的。每個節點的每個 IP 地址都必須被添加到每個集群節點上的 /etc/hosts。即使在每個節點上都配置了域名系統(DNS)的時候,也建議這樣做。例如:

# GPFS_CLUSTER1 Cluster - Test

# # GPFS Admin network - en0

10.1.5.110 aixlpar1a aixlpar1

10.1.5.120 aixlpar2a aixlpar2

# # GPFS Daemon - Private Network – en1

10.1.7.110 aixlpar1p

10.1.7.120 aixlpar2p

在 AIX 上安裝 GPFS

現在已經配置好了 AIX 環境,下一步是在每個節點上安裝 GPFS 軟件。這是一個非常簡單的過程。

我們將安裝 GPFS 版本 3.5(基礎級文件集),然後應用最新的更新升級到 3.5.0.10。只需三個文件集要安裝。您可以使用 System Management Interface Tool (SMIT) 或 installp 命令來安裝軟件。

aixlpar1 :/tmp/cg/GPFS/gpfs35_aix # inutoc .

aixlpar1 :/tmp/cg/GPFS/gpfs35_aix # ls -ltr

total 123024

-rw-r--r-- 1 root system 175104 Jun 7 2012 gpfs.msg.en_US

-rw-r--r-- 1 root system 868352 Jun 7 2012 gpfs.docs.data

-rw-r--r-- 1 root system 61939712 Jun 7 2012 gpfs.base

-rw-r--r-- 1 root system 3549 Apr 26 16:37 .toc

aixlpar1 :/tmp/cg/GPFS/gpfs35_aix # install –Y –d .ALL

在第二個節點上重復此操作。

您可以通過使用 lslpp 命令來驗證已安裝了基礎級別的 GPFS 文件集:

# lslpp -l | grep -i gpfs

gpfs.base 3.5.0.0 COMMITTED GPFS File Manager

gpfs.msg.en_US 3.5.0.0 COMMITTED GPFS Server Messages - U.S.

gpfs.base 3.5.0.0 COMMITTED GPFS File Manager

gpfs.docs.data 3.5.0.0 COMMITTED GPFS Server Manpages and

下一步是安裝最新的 GPFS 更新。同樣,可以使用 SMIT(或 installp)將文件集更新為最新的級別。lslpp 命令可用來驗證 GPFS 文件集已被更新。

aixlpar1 :/tmp/cg/gpfs_fixes_3510 # inutoc .

aixlpar1 :/tmp/cg/gpfs_fixes_3510 # ls -ltr

total 580864

-rw-r--r-- 1 30007 bin 910336 Feb 9 00:10 U858102.gpfs.docs.data.bff

-rw-r--r-- 1 30007 bin 47887360 May 8 08:48 U859646.gpfs.base.bff

-rw-r--r-- 1 30007 bin 99655680 May 8 08:48 U859647.gpfs.gnr.bff

-rw-r--r-- 1 30007 bin 193536 May 8 08:48 U859648.gpfs.msg.en_US.bff

-rw-r--r-- 1 root system 4591 May 10 05:15 changelog

-rw-r--r-- 1 root system 3640 May 10 05:42 README

-rw-r----- 1 root system 55931 May 15 10:23 GPFS-3.5.0.10-power-AIX.readme.html

-rw-r----- 1 root system 148664320 May 15 10:28 GPFS-3.5.0.10-power-AIX.tar

-rw-r--r-- 1 root system 8946 May 15 14:48 .toc

aixlpar1 :/tmp/cg/gpfs_fixes_3510 # smitty update_all

COMMAND STATUS

Command:OK stdout: yes stderr: no

Before command completion, additional instructions may appear below.

[MORE...59]

Finished processing all filesets.(Total time:18 secs).

+-----------------------------------------------------------------------------+

Pre-commit Verification...

+-----------------------------------------------------------------------------+

Verifying requisites...done

Results...

SUCCESSES

---------

Filesets listed in this section passed pre-commit verification

and will be committed.

Selected Filesets

-----------------

gpfs.base 3.5.0.10 # GPFS File Manager

gpfs.msg.en_US 3.5.0.9 # GPFS Server Messages - U.S. ...

<< End of Success Section >>

+-----------------------------------------------------------------------------+

Committing Software...

+-----------------------------------------------------------------------------+

installp:COMMITTING software for:

gpfs.base 3.5.0.10

Filesets processed:1 of 2 (Total time:18 secs).

installp:COMMITTING software for:

gpfs.msg.en_US 3.5.0.9

Finished processing all filesets.(Total time:18 secs).

+-----------------------------------------------------------------------------+

Summaries:

+-----------------------------------------------------------------------------+

Installation Summary

--------------------

Name Level Part Event Result

-------------------------------------------------------------------------------

gpfs.msg.en_US 3.5.0.9 USR APPLY SUCCESS

gpfs.base 3.5.0.10 USR APPLY SUCCESS

gpfs.base 3.5.0.10 ROOT APPLY SUCCESS

gpfs.base 3.5.0.10 USR COMMIT SUCCESS

gpfs.base 3.5.0.10 ROOT COMMIT SUCCESS

gpfs.msg.en_US 3.5.0.9 USR COMMIT SUCCESS

aixlpar1 :/tmp/cg/gpfs_fixes_3510 # lslpp -l gpfs\*

Fileset Level State Description

----------------------------------------------------------------------------

Path:/usr/lib/objrepos

gpfs.base 3.5.0.10 COMMITTED GPFS File Manager

gpfs.msg.en_US 3.5.0.9 COMMITTED GPFS Server Messages - U.S.

English

Path:/etc/objrepos

gpfs.base 3.5.0.10 COMMITTED GPFS File Manager

Path:/usr/share/lib/objrepos

gpfs.docs.data 3.5.0.3 COMMITTED GPFS Server Manpages and

Documentation

在第二個節點上重復此更新。

配置 GPFS 集群

現在,GPFS 已被安裝,我們可以跨兩個 AIX 系統創建一個集群。首先,我們創建了一個文本文件,其中包含一個列表,列出了每個節點以及它們的 GPFS 描述和用途。我們選擇將每個節點都配置為一個 GPFS 仲裁管理器(quorum manager)。每個節點都是一個 GPFS 服務器。如果您不確定在您的環境中需要多少仲裁管理器和 GPFS 服務器,請參閱 GPFS Concepts, Planning, and Installation 文檔 以獲得相關指南。

aixlpar1 :/tmp/cg # cat gpfs-nodes.txt

aixlpar2p:quorum-manager:

aixlpar1p:quorum-manager:

使用 mmcrcluster 命令創建集群。*GPFS 集群名稱是 GPFS_CLUSTER1。主節點(或 NSD 服務器,將在下一節討論)是 aixlpar1p ,二級節點是 aixlpar2p。我們已經指定,ssh 和 scp 將用於集群通信和管理。

aixlpar1 :/tmp/cg # mmcrcluster –C GPFS_CLUSTER1 -N /tmp/cg/gpfs-nodes.txt -p

aixlpar1p -s aixlpar2p -r /usr/bin/ssh -R /usr/bin/scp

Mon Apr 29 12:01:21 EET 2013: mmcrcluster:Processing node aixlpar2

Mon Apr 29 12:01:24 EET 2013: mmcrcluster:Processing node aixlpar1

mmcrcluster:Command successfully completed

mmcrcluster:Warning:Not all nodes have proper GPFS license designations.

Use the mmchlicense command to designate licenses as needed.

mmcrcluster:Propagating the cluster configuration data to all

affected nodes.This is an asynchronous process.

*備注:為了確保 GPFS 守護進程通信是在專有 GPFS 網絡上進行的,在創建集群的過程中,我們指定了 GPFS 守護進程節點名稱(即以 p 結尾的主機名)。在 GPFS 集群中要考慮兩種類型的通信:管理命令通信和守護進程通信。管理命令使用遠程 shell(ssh、 rsh 或其他 shell)和基於套接字的通信。確保所有 GPFS 守護進程通信 在 專有網絡上執行,這被認為是一種最佳實踐。請參閱 GPFS developerWorks 維基,了解有關 GPFS 網絡配置考慮因素與實踐的更多信息和討論。

為了使用單獨的網絡進行管理命令通信,您可以使用 mmchnode 命令修改 “管理節點名稱”。在本例中,單獨的網絡地址由節點名稱末尾的 a”(代表 Administration)指定,例如 aixlpar1a。

# mmchnode -admin-interface=aixlpar1p -N aixlpar1a

# mmchnode -admin-interface=aixlpar2p -N aixlpar2a

mmcrcluster 命令警告我們,不是所有節點都有適當的 GPFS 許可分配。我們使用 mmchlicense 命令將 GPFS 服務器許可分配給集群中的兩個節點。

aixlpar1 :/ # mmchlicense server --accept -N aixlpar1a,aixlpar2a

The following nodes will be designated as possessing GPFS server licenses:

aixlpar2a

aixlpar1a

mmchlicense:Command successfully completed

mmchlicense:Propagating the cluster configuration data to all

affected nodes.This is an asynchronous process.

該集群現在已完成配置。mmlscluster 命令可以用於顯示集群信息。

# mmlscluster

GPFS cluster information

========================

GPFS cluster name: GPFS_CLUSTER1.aixlpar1p

GPFS cluster id: 8831612751005471855

GPFS UID domain: GPFS_CLUSTER.aixlpar1p

Remote shell command: /usr/bin/ssh

Remote file copy command:/usr/bin/scp

GPFS cluster configuration servers:

-----------------------------------

Primary server: aixlpar1p

Secondary server:aixlpar2p

Node Daemon node name IP address Admin node name Designation

----------------------------------------------------------------------

1 aixlpar2p 10.1.7.120 aixlpar2a quorum-manager

2 aixlpar1p 10.1.7.110 aixlpar1a quorum-manager

此時,您可以使用 mmdsh 命令,驗證 SSH 通信在所有 GPFS 節點上如期運行。這會在集群中的所有節點上運行一個命令。如果存在 SSH 配置問題,該命令可以突出顯示問題。

aixlpar1 :/ # mmdsh date

aixlpar1:Mon Apr 29 12:05:47 EET 2013

aixlpar2:Mon Apr 29 12:05:47 EET 2013

aixlpar2 :/ # mmdsh date

aixlpar1:Mon Apr 29 12:06:41 EET 2013

aixlpar2:Mon Apr 29 12:06:41 EET 2013

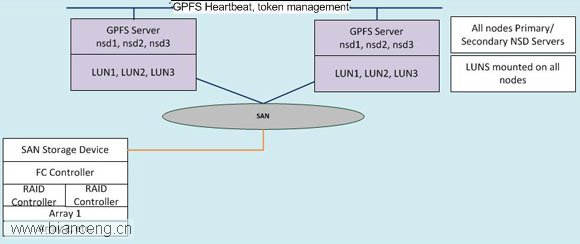

GPFS 在 TCP/IP 網絡上提供了一個塊級(block-level)接口,稱為網絡共享磁盤(Network Shared Disk,NSD)協議。無論使用 NSD 協議還是直接連接到 SAN,掛載的文件系統對於用戶和應用程序而言看起來都是一樣的(GPFS 透明地處理 I/O 請求)。

共享磁盤集群是最基本的環境。在此配置中,存儲被直接連接到集群中的所有系統。直接連接意味著每個共享塊設備都同時可用於 GPFS 集群中的所有節點。直接訪問還意味著可以使用 Small Computer System Interface (SCSI) 或其他使用 SAN 的塊級協議來訪問存儲。

下圖顯示了一個 GPFS 集群,所有節點都連接到一個公共的光纖通道 SAN 和存儲設備。使用 SAN 將各節點連接到存儲,並使用本地區域網絡(LAN)讓它們彼此連接。在 GPFS 節點上運行的應用程序所使用的數據會流過 SAN,GPFS 控制著集群中的 GPFS 實例之中的信息流過 LAN。如果集群中的所有節點都需要獲得最高的數據訪問性能,那麼此配置是最佳配置。

查看本欄目更多精彩內容:http://www.bianceng.cn/OS/unix/

mmcrnsd 命令用於為 GPFS 創建 NSD 設備。首先,我們創建一個文本文件,其中包含一個列表,列出了每個 hdisk 名稱、它們的 GPFS 分配(數據、元數據、兩者兼有*)和 NSD 名稱。

hdisk1:::dataAndMetadata::nsd01::

hdisk2:::dataAndMetadata::nsd02::

hdisk3:::dataAndMetadata::nsd03::

hdisk4:::dataAndMetadata::nsd04::

hdisk5:::dataAndMetadata::nsd05::

hdisk6:::dataAndMetadata::nsd06::

*備注:請參閱 GPFS Concepts, Planning, and Installation 文檔,獲得有關選擇 NSD 設備使用類型的指南。

然後,運行 mmcrnsd 命令,創建 NSD 設備。

# mmcrnsd -F /tmp/cg/gpfs-disks.txt

mmcrnsd:Processing disk hdisk1

mmcrnsd:Processing disk hdisk2

mmcrnsd:Processing disk hdisk3

mmcrnsd:Processing disk hdisk4

mmcrnsd:Processing disk hdisk5

mmcrnsd:Processing disk hdisk6

mmcrnsd:Propagating the cluster configuration data to all

affected nodes.This is an asynchronous process.

現在,lspv 命令顯示了與每個 AIX hdisk 有關聯的 NSD 名稱。

# lspv

hdisk0 00c334b6af00e77b rootvg active

hdisk1 none nsd01

hdisk2 none nsd02

hdisk3 none nsd03

hdisk4 none nsd04

hdisk5 none nsd05

hdisk6 none nsd06

mmlsnsd 命令顯示了每個 NSD 的信息,尤其是每個設備與哪個 GPFS 文件系統有關聯。此時,我們還沒有創建 GPFS 文件系統。因此,每個磁盤目前都是空閒的。您會注意到,在 NSD 服務器 下面,每個設備都被顯示為直接附加。這是所期望的 SAN 附加磁盤的附加方式。

# mmlsnsd

File system Disk name NSD servers

---------------------------------------------------------------------------

(free disk) nsd01 (directly attached)

(free disk) nsd02 (directly attached)

(free disk) nsd03 (directly attached)

(free disk) nsd04 (directly attached)

(free disk) nsd05 (directly attached)

(free disk) nsd06 (directly attached)

GPFS 文件系統配置

接下來,可以對 GPFS 文件系統進行配置。mmcrfs 命令用於創建文件系統。我們選擇了創建兩個文件系統;/gpfs 和 /gpfs1。/gpfs (gpfs0) 文件系統將被配置了一個大小為 256K(默認)的 GPFS 塊,並且 /gpfs1 (gpfs1) 的塊大小將被配置為 1M*。兩個文件系統都針對復制進行了配置 (-M2 –R2)。為 /gpfs 指定 /tmp/cg/gpfs-disk.txt 文件,並為 /gpfs1 指定 /tmp/cg/gpfs1-disk.txt。這些文件指定了在創建過程中每個文件系統使用哪些 NSD 設備。

*備注:小心地選擇塊大小。在已經創建 GPFS 設備後,就無法再更改這個值。

# cat /tmp/cg/gpfs-disk.txt

nsd01:::dataAndMetadata:-1::system

nsd02:::dataAndMetadata:-1::system

nsd03:::dataAndMetadata:-1::system

# cat /tmp/cg/gpfs1-disk.txt

nsd04:::dataAndMetadata:-1::system

nsd05:::dataAndMetadata:-1::system

nsd06:::dataAndMetadata:-1::system

# mmcrfs /gpfs gpfs0 -F/tmp/cg/gpfs-disks.txt -M2 -R 2

# mmcrfs /gpfs1 gpfs1 -F/tmp/cg/gpfs1-disks.txt -M2 -R 2 –B 1M

mmlsnsd 命令顯示每個文件系統的 NSD 配置。NSD 設備 1 至 3 被分配到 gpfs0,而設備 4 至 6 被分配到 gpfs1。

# mmlsnsd

File system Disk name NSD servers

---------------------------------------------------------------------------

gpfs0 nsd01 (directly attached)

gpfs0 nsd02 (directly attached)

gpfs0 nsd03 (directly attached)

gpfs1 nsd04 (directly attached)

gpfs1 nsd05 (directly attached)

gpfs1 nsd06 (directly attached)

現在,兩個 GPFS 文件系統在兩個節點上均可用。

aixlpar1 :/ # df -g

Filesystem GB blocks Free %Used Iused %Iused Mounted on

/dev/hd4 1.00 0.89 12% 5211 3% /

/dev/hd2 3.31 0.96 71% 53415 18% /usr

/dev/hd9var 2.00 1.70 16% 5831 2% /var

/dev/hd3 2.00 1.36 33% 177 1% /tmp

/dev/hd1 2.00 2.00 1% 219 1% /home

/proc - - - - - /proc

/dev/hd10opt 1.00 0.79 21% 3693 2% /opt

/dev/local 1.00 0.97 3% 333 1% /usr/local

/dev/loglv 1.00 1.00 1% 54 1% /var/log

/dev/tsmlog 1.00 1.00 1% 7 1% /var/tsm/log

/dev/hd11admin 0.12 0.12 1% 13 1% /admin

/dev/optIBMlv 2.00 1.99 1% 17 1% /opt/IBM

/dev/gpfs1 150.00 147.69 2% 4041 3% /gpfs1

/dev/gpfs0 150.00 147.81 2% 4041 7% /gpfs

在這裡,可以使用 mmdsh 命令快速檢查所有節點上的文件系統狀態。

aixlpar1 :/ # mmdsh df -g | grep gpfs

aixlpar2:/dev/gpfs0 150.00 147.81 2% 4041 7% /gpfs

aixlpar2:/dev/gpfs1 150.00 147.69 2% 4041 3% /gpfs1

aixlpar1:/dev/gpfs1 150.00 147.69 2% 4041 3% /gpfs1

aixlpar1:/dev/gpfs0 150.00 147.81 2% 4041 7% /gpfs

如果需要更詳細的信息,可以使用 mmdf 命令。

aixlpar1 :/gpfs # mmdf gpfs0 --block-size=auto

disk disk size failure holds holds free free

name group metadata data in full blocks in fragments

--------------- ------------- -------- -------- ----- -------------------- ------------

Disks in storage pool: system (Maximum disk size allowed is 422 GB)

nsd01 50G -1 yes yes 49.27G ( 99%) 872K ( 0%)

nsd02 50G -1 yes yes 49.27G ( 99%) 936K ( 0%)

nsd03 50G -1 yes yes 49.27G ( 99%) 696K ( 0%)

------------- -------------------- -------------------

(pool total) 150G 147.8G ( 99%) 2.445M ( 0%)

============= ==================== ===================

(total) 150G 147.8G ( 99%) 2.445M ( 0%)

Inode Information

-----------------

Number of used inodes: 4040

Number of free inodes: 62008

Number of allocated inodes: 66048

Maximum number of inodes: 66048

aixlpar1 :/gpfs # mmdf gpfs1 --block-size=auto

disk disk size failure holds holds free free

name group metadata data in full blocks in fragments

--------------- ------------- -------- -------- ----- --------------------

Disks in storage pool: system (Maximum disk size allowed is 784 GB)

nsd04 50G -1 yes yes 49.55G ( 99%) 1.938M ( 00%)

nsd05 50G -1 yes yes 49.56G ( 99%) 992K ( 0%)

nsd06 50G -1 yes yes 49.56G ( 99%) 1.906M ( 00%)

------------- -------------------- -------------------

(pool total) 150G 148.7G ( 99%) 4.812M ( 00%)

============= ==================== ===================

(total) 150G 148.7G ( 99%) 4.812M ( 00%)

Inode Information

-----------------

Number of used inodes: 4040

Number of free inodes: 155704

Number of allocated inodes: 159744

Maximum number of inodes: 159744

通過決勝(tiebreaker)磁盤進行節點仲裁

如果您有一個雙節點集群,或者集群中所有節點都通過 SAN 連接到一組公共的邏輯單元號(LUN),並且您想繼續通過單一幸存節點(surviving node)提供數據,那麼我們建議使用決勝磁盤(tiebreaker disk)。通常情況下,只在雙節點集群中使用決勝磁盤。決勝磁盤不是特殊的 NSD;您可以使用任何 NSD 作為決勝磁盤。

在本例中,我們選擇了三個(總數為六個)NSD 設備作為決勝磁盤。我們在所有節點上停止 GPFS,並相應地配置了集群。

# mmshutdown -N

# mmchconfig tiebreakerDisks="nsd01;nsd03;nsd05"

# mmstartup -a

集群守護進程狀態

在 GPFS 處於活動狀態時,有兩個 GPFS 守護進程仍然處於活動狀態(mmfsd64 和 runmmfs)。

# ps -ef | grep mmfs

root 4784176 5505220 0 May 20 - 0:27 /usr/lpp/mmfs/bin/aix64/mmfsd64

root 5505220 1 0 May 20 - 0:00 /usr/lpp/mmfs/bin/mmksh /usr/lpp/mmfs/bin/runmmfs

您可以使用 mmgetstate 命令來查看集群中所有節點上的 GPFS 守護進程的狀態。

# mmgetstate -aLs

Node number Node name Quorum Nodes up Total nodes GPFS state Remarks

------------------------------------------------------------------------------------

1 aixlpar2a 1* 2 2 active quorum node

2 aixlpar1a 1* 2 2 active quorum node

Summary information

---------------------

Number of nodes defined in the cluster: 2

Number of local nodes active in the cluster: 2

Number of remote nodes joined in this cluster: 0

Number of quorum nodes defined in the cluster: 2

Number of quorum nodes active in the cluster: 2

Quorum = 1*, Quorum achieved

結束語

恭喜您!您剛剛配置了自己的第一個 GPFS 集群。在本文中,您已經學會了如何在 AIX 上構建一個簡單的雙節點 GPFS 集群。可以輕松地部署這種類型的配置,以支持具有高可用性需求的集群工作負載,例如 MQ 多實例集群。GPFS 提供了許多配置選項;規劃 GPFS 集群可能要花很長時間。