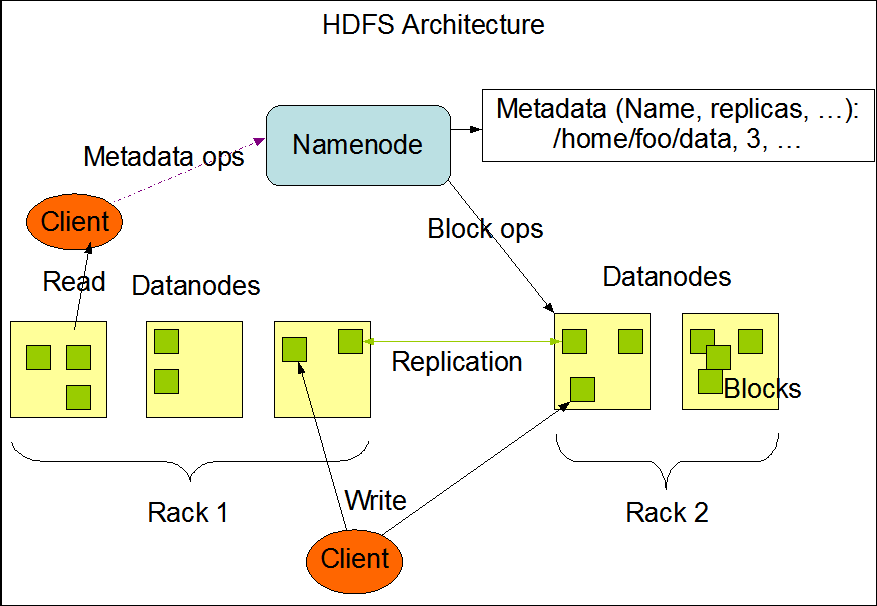

HDFS架構圖

Hadoop的框架最核心的設計就是:HDFS和MapReduce。HDFS為海量的數據提供了存儲,則MapReduce為海量的數據提供了計算。

HDFS(Hadoop Distribution File System),稱為Hadoop分布式文件系統,主要特點:

客戶端,提交MapReduce作業;jobtracker,協調作業的運行,jobtracker是一個java應用程序,它的主類是JobTracker;tasktracker。運行作業劃分後的任務,tasktracker是一個java應用程序,TaskTracker是主類。

2、Hadoop優點Hadoop是一個能夠讓用戶輕松架構和使用的分布式計算平台。用戶可以輕松地在Hadoop上開發和運行處理海量數據的應用程序。它主要有以下幾個優點:

高可靠性:Hadoop按位存儲和處理數據的能力值得人們信賴。

高擴展性:Hadoop是在可用的計算機集簇間分配數據並完成計算任務的,這些集簇可以方便地擴展到數以千計的節點中。

高效性:Hadoop能夠在節點之間動態地移動數據,並保證各個節點的動態平衡,因此處理速度非常快。

高容錯性:Hadoop能夠自動保存數據的多個副本,並且能夠自動將失敗的任務重新分配。

低成本:與一體機、商用數據倉庫以及QlikView、Yonghong Z-Suite等數據集市相比,hadoop是開源的,項目的軟件成本因此會大大降低。

Hadoop帶有用Java語言編寫的框架,因此運行在 Linux 生產平台上是非常理想的。Hadoop 上的應用程序也可以使用其他語言編寫,比如 C++。

Hadoop官網:http://hadoop.apache.org/

二、先決條件保持Hadoop集群每個節點配置環境一致,安裝java,配置ssh。

實驗環境:

Platform:xen vm

OS: CentOS 6.8

Software: hadoop-2.7.3-src.tar.gz, jdk-8u101-linux-x64.rpm

HostnameIP AddressOS versionHadoop roleNode rolelinux-node1192.168.0.89CentOS 6.8Masternamenodelinux-node2192.168.0.90CentOS 6.8Slavedatenodelinux-node3192.168.0.91CentOS 6.8Slavedatenodelinux-node4192.168.0.92CentOS 6.8Slavedatenode#把需要的軟件包下載下來上傳到集群的各個節點上

三、集群的構架和安裝1、Hosts文件設置#Hadoop集群中的每個節點的hosts文件都需要修改

[root@linux-node1 ~]# cat /etc/hosts127.0.0.1 localhost localhost.localdomain linux-node1192.168.0.89 linux-node1192.168.0.90 linux-node2192.168.0.91 linux-node3192.168.0.92 linux-node42、安裝java

#提前把下載好的JDK(rpm包)上傳到服務器上,然後安裝

rpm -ivh jdk-8u101-linux-x64.rpmexport JAVA_HOME=/usr/java/jdk1.8.0_101/export PATH=$JAVA_HOME/bin:$PATH# java -versionjava version "1.8.0_101"Java(TM) SE Runtime Environment (build 1.8.0_101-b13)Java HotSpot(TM) 64-Bit Server VM (build 25.101-b13, mixed mode)3、安裝hadoop

#創建hadoop用戶,設置使用sudo

[root@linux-node1 ~]# useradd hadoop && echo hadoop | passwd --stdin hadoop[root@linux-node1 ~]# echo "hadoopALL=(ALL) NOPASSWD:ALL" >> /etc/sudoers[root@linux-node1 ~]# su - hadoop[hadoop@linux-node1 ~]$ cd /usr/local/src/[hadoop@linux-node1src]$wget http://apache.fayea.com/hadoop/common/hadoop-2.7.3/hadoop-2.7.3.tar.gz[hadoop@linux-node1 src]$ sudo tar zxvf hadoop-2.7.3.tar.gz -C /home/hadoop/ && cd /home/hadoop[hadoop@linux-node1 home/hadoop]$ sudo mv hadoop-2.7.3/ hadoop[hadoop@linux-node1 home/hadoop]$ sudo chown -R hadoop:hadoop hadoop/

#將hadoop的二進制目錄添加到PATH變量,並設置HADOOP_HOME環境變量

[hadoop@linux-node1 home/hadoop]$ export HADOOP_HOME=/home/hadoop/hadoop/[hadoop@linux-node1 home/hadoop]$ export PATH=$HADOOP_HOME/bin:$PATH4、創建hadoop相關目錄

[hadoop@linux-node1 ~]$ mkdir -p /home/hadoop/dfs/{name,data}[hadoop@linux-node1 ~]$ mkdir -p /home/hadoop/tmp#節點存儲數據備份目錄

sudo mkdir -p /data/hdfs/{name,data}sudo chown -R hadoop:hadoop /data/#上述操作需在hadoop集群的每個節點都操作

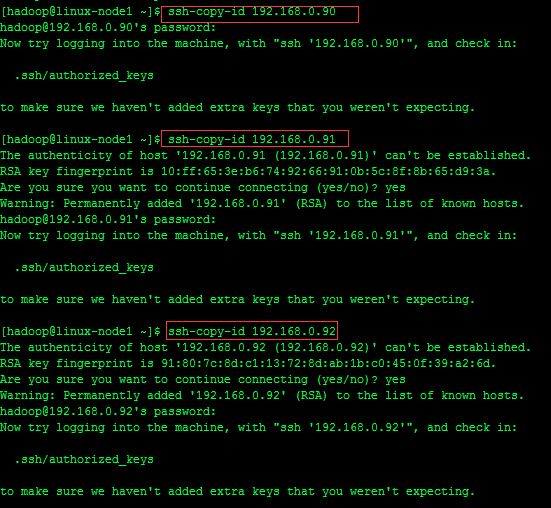

5、SSH配置#設置集群主節點免密碼登陸其他節點

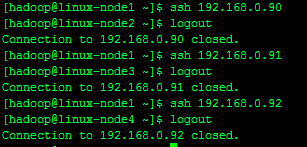

[hadoop@linux-node1 ~]$ ssh-keygen -t rsa[hadoop@linux-node1 ~]$ ssh-copy-id [email protected][hadoop@linux-node1 ~]$ ssh-copy-id [email protected][hadoop@linux-node1 ~]$ ssh-copy-id [email protected]

#測試ssh登錄

文件位置:/home/hadoop/hadoop/etc/hadoop,文件名稱:hadoop-env.sh、yarn-evn.sh、slaves、core-site.xml、hdfs-site.xml、mapred-site.xml、 yarn-site.xml

(1)配置hadoop-env.sh文件

#在hadoop安裝路徑下,進入hadoop/etc/hadoop/目錄並編輯hadoop-env.sh,修改JAVA_HOME為JAVA的安裝路徑

[hadoop@linux-node1 home/hadoop]$ cd hadoop/etc/hadoop/[hadoop@linux-node1 hadoop]$ egrep JAVA_HOME hadoop-env.sh# The only required environment variable is JAVA_HOME. All others are# set JAVA_HOME in this file, so that it is correctly defined on#export JAVA_HOME=${JAVA_HOME}export JAVA_HOME=/usr/java/jdk1.8.0_101/(2)配置yarn.sh文件

指定yran框架的java運行環境,該文件是yarn框架運行環境的配置文件,需要修改JAVA_HOME的位置。

[hadoop@linux-node1 hadoop]$ grep JAVA_HOME yarn-env.sh# export JAVA_HOME=/home/y/libexec/jdk1.6.0/export JAVA_HOME=/usr/java/jdk1.8.0_101/

(3)配置slaves文件

指定DataNode數據存儲服務器,將所有的DataNode的機器的主機名寫入到此文件中,如下:

[hadoop@linux-node1 hadoop]$ cat slaveslinux-node2linux-node3linux-node4

Hadoop 3種運行模式

本地獨立模式:Hadoop的所有組件,如NameNode,DataNode,Jobtracker,Tasktracker都運行在一個java進程中。

偽分布式模式:Hadoop的各個組件都擁有一個單獨的Java虛擬機,它們之間通過網絡套接字通信。

完全分布式模式:Hadoop分布在多台主機上,不同的組件根據工作性質的不同安裝在不通的Guest上。

#配置完全分布式模式

(4)修改core-site.xml文件,添加紅色區域的代碼,注意藍色標注的內容

<configuration><property><name>fs.default.name</name><value>hdfs://linux-node1:9000</value></property><property><name>io.file.buffer.size</name><value>131072</value></property><property><name>hadoop.tmp.dir</name><value>file:/home/hadoop/tmp</value><description>Abase for other temporary directories.</description></property></configuration>

(5)修改hdfs-site.xml文件

<configuration><property><name>dfs.namenode.secondary.http-address</name><value>linux-node1:9001</value><description># 通過web界面來查看HDFS狀態 </description></property><property><name>dfs.namenode.name.dir</name><value>file:/home/hadoop/dfs/name</value></property><property><name>dfs.datanode.data.dir</name><value>file:/home/hadoop/dfs/data</value></property><property><name>dfs.replication</name><value>2</value><description># 每個Block有2個備份</description></property><property><name>dfs.webhdfs.enabled</name><value>true</value></property></configuration>

(6)修改mapred-site.xml

這個是mapreduce任務的配置,由於hadoop2.x使用了yarn框架,所以要實現分布式部署,必須在mapreduce.framework.name屬性下配置為yarn。mapred.map.tasks和mapred.reduce.tasks分別為map和reduce的任務數。

[hadoop@linux-node1 hadoop]$ cp mapred-site.xml.template mapred-site.xml<configuration><property><name>mapreduce.framework.name</name><value>yarn</value></property><property><name>mapreduce.jobhistory.address</name><value>linux-node1:10020</value></property><property><name>mapreduce.jobhistory.webapp.address</name><value>linux-node1:19888</value></property></configuration>

(7)配置節點yarn-site.xml

#該文件為yarn架構的相關配置

<?xml version="1.0"?><!-- mapred-site.xml --><configuration><property><name>mapred.child.java.opts</name><value>-Xmx400m</value><!--Not marked as final so jobs can include JVM debuggung options --></property></configuration><?xml version="1.0"?><!-- yarn-site.xml --><configuration><!-- Site specific YARN configuration properties --><property><name>yarn.nodemanager.aux-services</name><value>mapreduce_shuffle</value></property><property><name>yarn.nodemanager.aux-services.mapreduce.shuffle.class</name><value>org.apache.hadoop.mapred.ShuffleHandler</value></property><property><name>yarn.resourcemanager.address</name><value>linux-node1:8032</value></property><property><name>yarn.resourcemanager.scheduler.address</name><value>linux-node1:8030</value></property><property><name>yarn.resourcemanager.resource-tracker.address</name><value>linux-node1:8031</value></property><property><name>yarn.resourcemanager.admin.address</name><value>linux-node1:8033</value></property><property><name>yarn.resourcemanager.webapp.address</name><value>linux-node1:8088</value></property><property><name>yarn.nodemanager.resource.memory-mb</name><value>8192</value></property></configuration>7、復制hadoop到其他節點

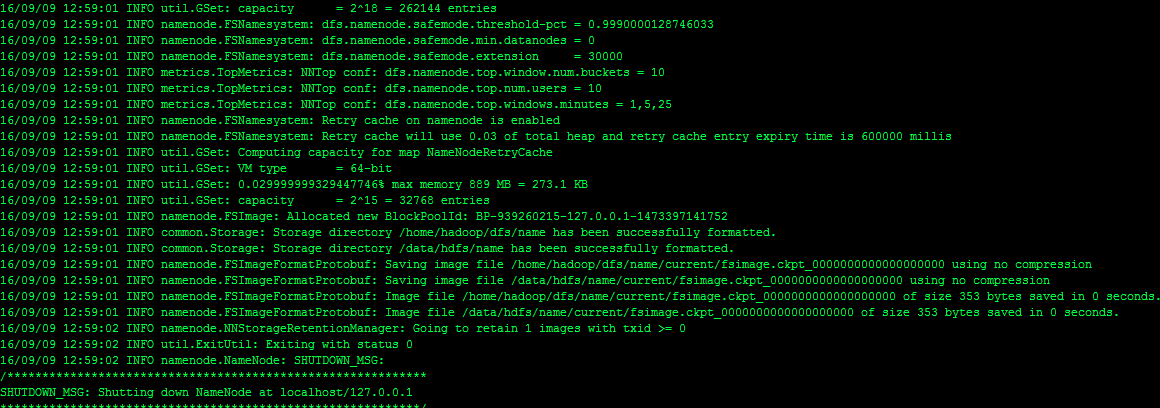

scp -r /home/hadoop/hadoop/ 192.168.0.90:/home/hadoop/scp -r /home/hadoop/hadoop/ 192.168.0.91:/home/hadoop/scp -r /home/hadoop/hadoop/ 192.168.0.92:/home/hadoop/8、在linux-node1使用hadoop用戶初始化NameNode

/home/hadoop/hadoop/bin/hdfs namenode –format

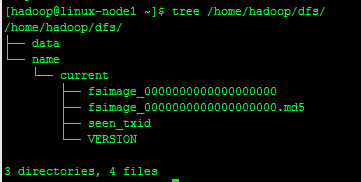

#echo $?#sudo yum –y install tree# tree /home/hadoop/dfs

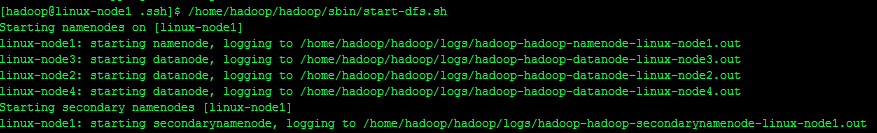

/home/hadoop/hadoop/sbin/start-dfs.sh/home/hadoop/hadoop/sbin/stop-dfs.sh

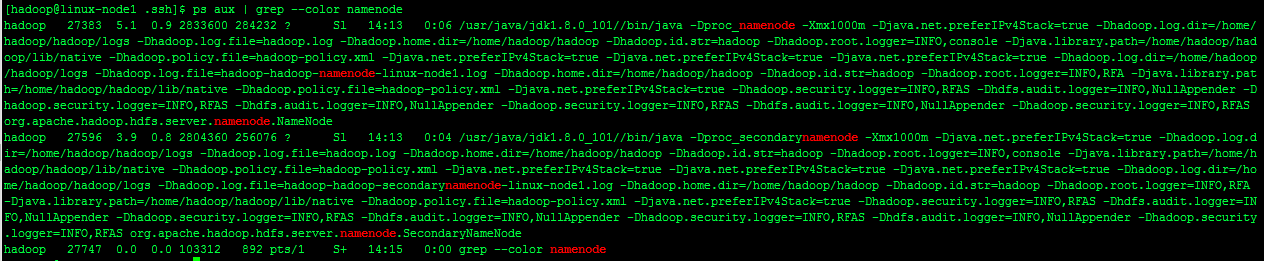

#namenode節點上面查看進程

ps aux | grep --color namenode

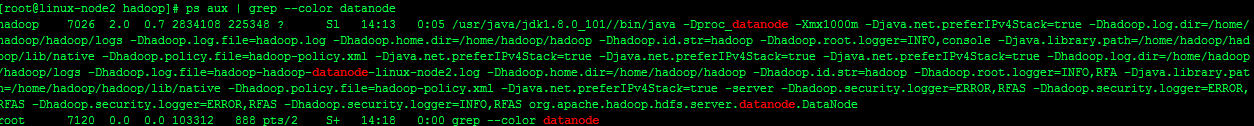

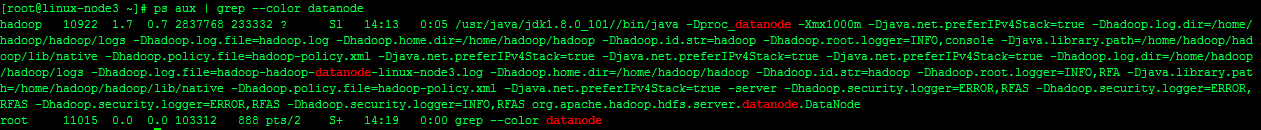

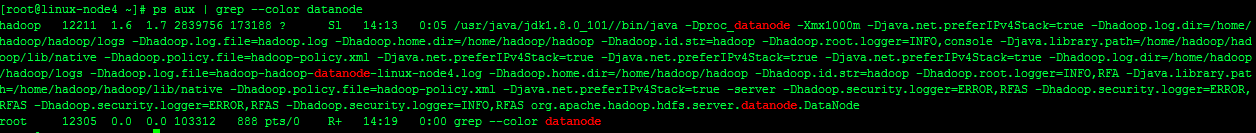

#DataNode上面查看進程

ps aux | grep --color datanode

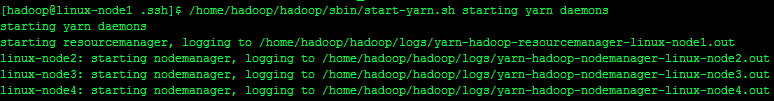

[hadoop@linux-node1 .ssh]$ /home/hadoop/hadoop/sbin/start-yarn.sh starting yarn daemons

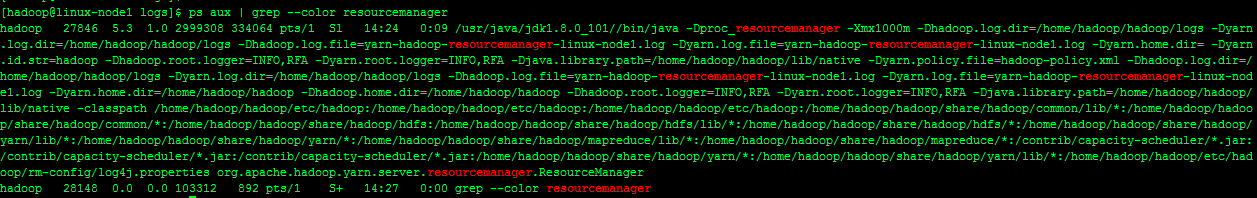

#NameNode節點上查看進程

ps aux | grep --color resourcemanager

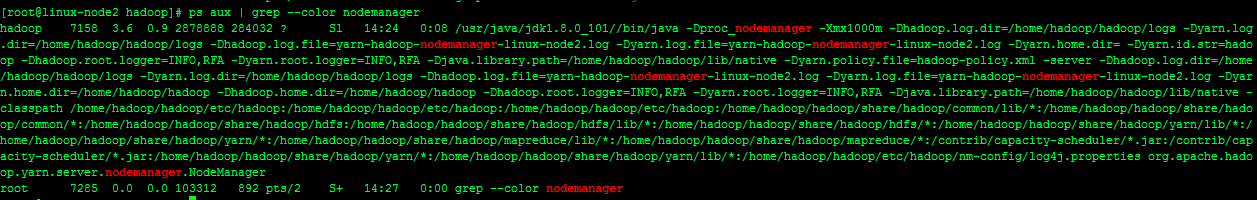

#DataNode節點上查看進程

ps aux | grep --color nodemanager

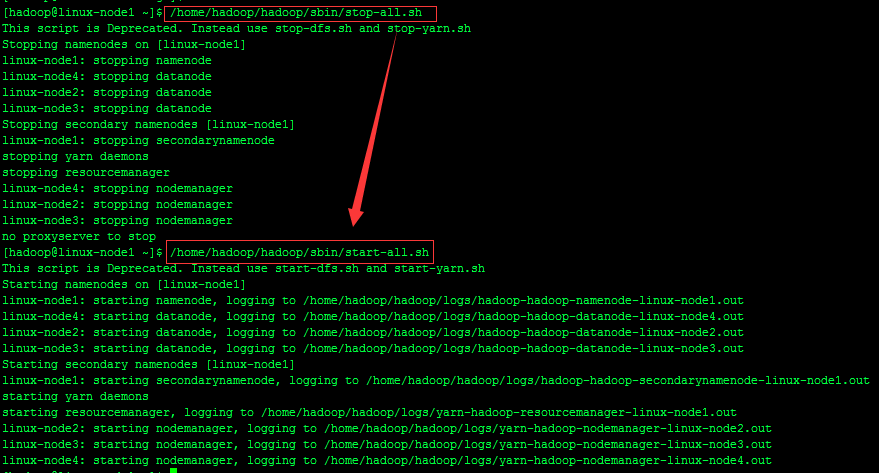

注:start-dfs.sh和start-yarn.sh這兩個腳本可用start-all.sh代替

/home/hadoop/hadoop/sbin/stop-all.sh/home/hadoop/hadoop/sbin/start-all.sh

#在NameNode節點上

[hadoop@linux-node1 ~]$ /home/hadoop/hadoop/sbin/mr-jobhistory-daemon.sh start historyserverstarting historyserver, logging to /home/hadoop/hadoop/logs/mapred-hadoop-historyserver-linux-node1.out12、查看HDFS分布式文件系統狀態

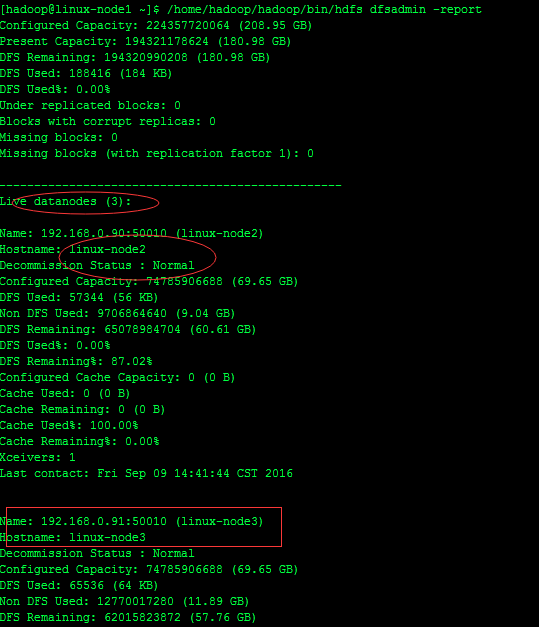

/home/hadoop/hadoop/bin/hdfs dfsadmin –report

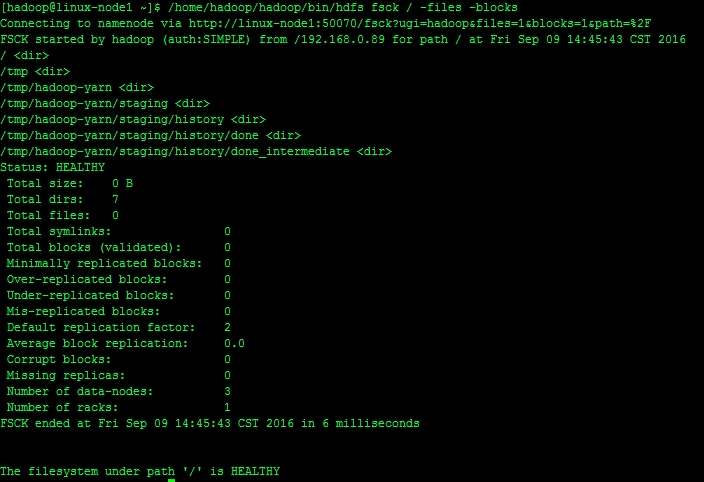

#查看文件塊組成,一個文件由那些塊組成

/home/hadoop/hadoop/bin/hdfs fsck / -files -blocks

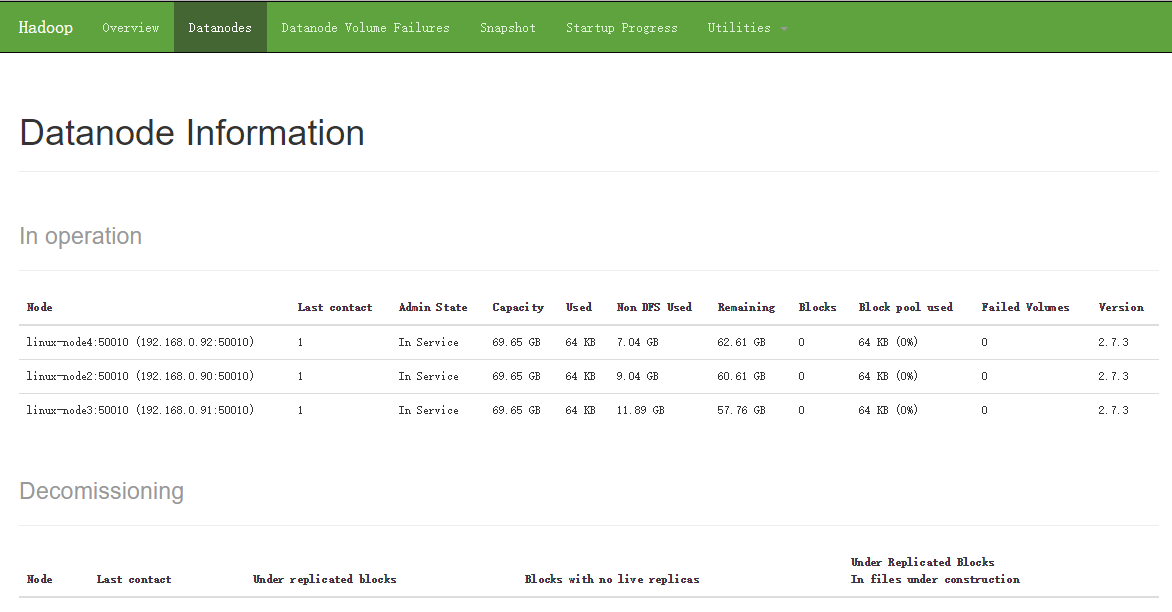

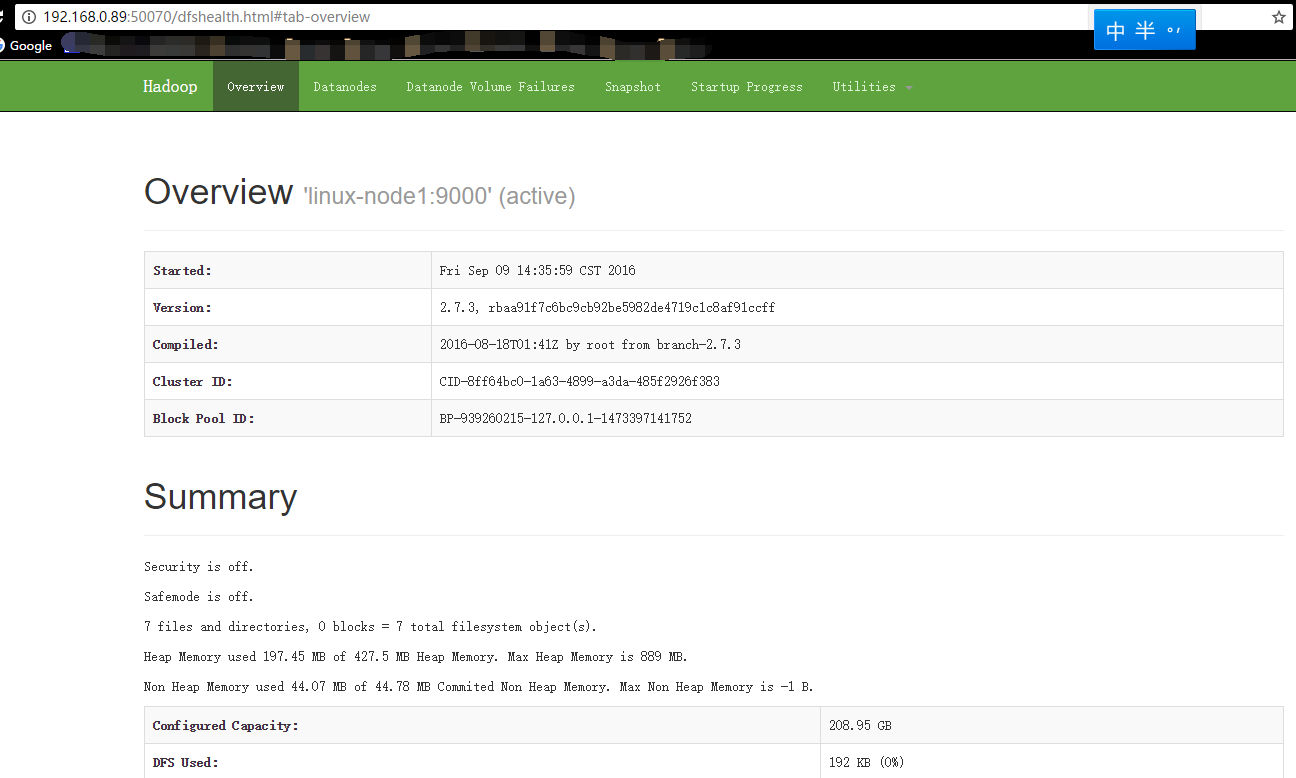

查看HDFS狀態:http://192.168.0.89:50070/

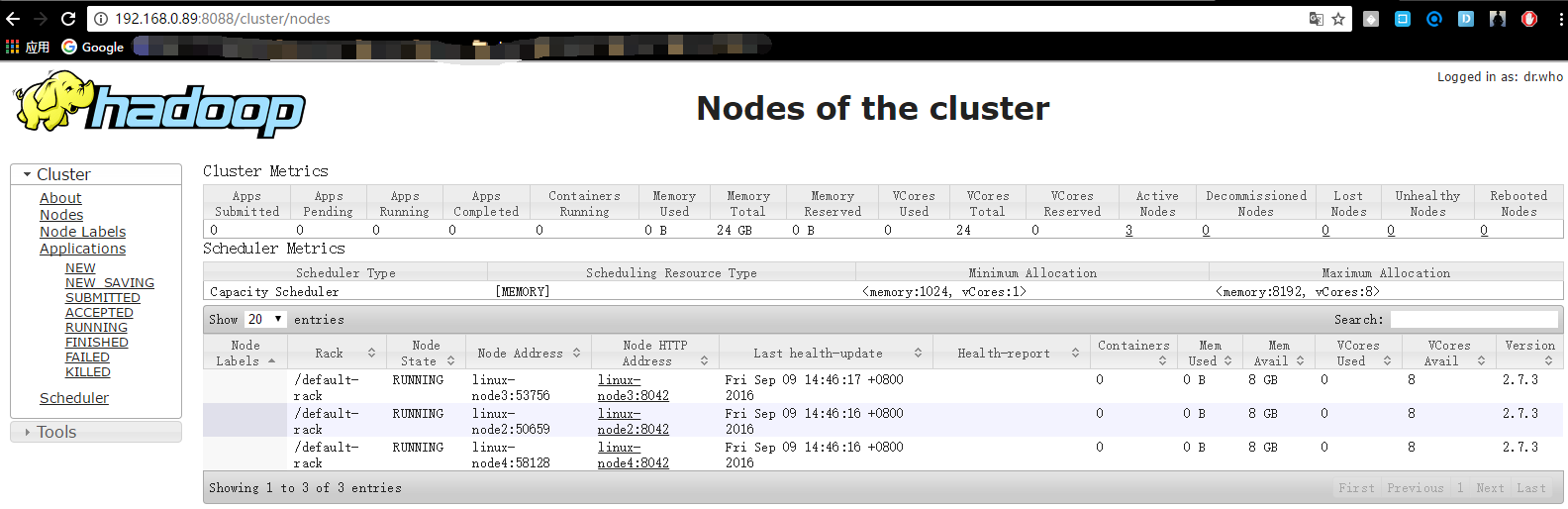

查看Hadoop集群狀態:http://192.168.0.89:8088/

本文原創地址:http://www.linuxprobe.com/centos-deploy-hadoop-cluster.html

http://xxxxxx/Linuxjc/1184698.html TechArticle